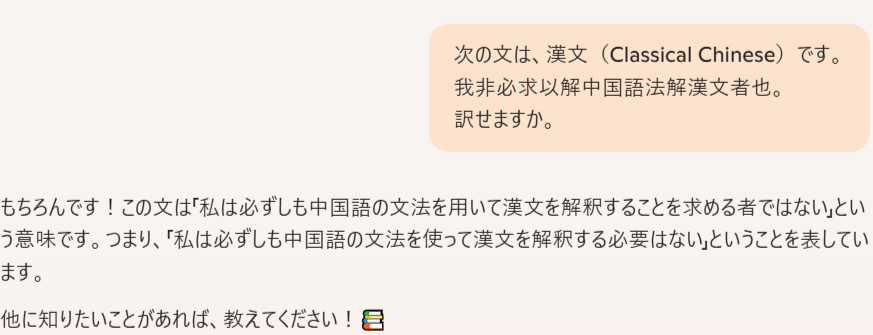

(01)

① 我非必求以解中国語法解漢文者也=

② 我非{必求[以〔解(中国語)法〕解(漢文)]者}也⇒

③ 我{必[〔(中国語)解法〕以(漢文)解]求者}非也=

④ 我は{必ずしも[〔(中国語を)解する法を〕以て(漢文を)解せんことを]求むる者に}非ざるなり=

⑤ 私は{必ずしも[〔(中国語を)解する方法を〕用いて(漢文を)解することを]求める者では}ないのである。

というのは、「昔、私が作って、ネット上にアップロードした、日本漢文」である。

従って、

(01)により、

(02)

「生成AI(コパイロット)」による、

という「回答」は、「私から、教わった」のかも、知れない(?!)。

然るに、

(03)

「生成AI(大規模言語モデル)」の基本的な仕組みを教えて下さい。

大量のテキストデータ: LLMは、インターネット上の膨大なテキストデータ(書籍、記事、ウェブサイト、会話記録など)を学習します。このデータセットはテラバイト規模に及びます。

自己教師あり学習: 人間によるラベル付けはほとんど必要ありません。モデルは、テキスト内の単語の関係性を学習するために、文中の単語の一部を隠したり、次の単語を予測したりするタスクを自身に課します。―「中略」―

まとめると、LLMは大量のテキストデータから言語のパターンを統計的に学習し、その知識を使って、与えられた入力に基づいて次に続く単語を予測・生成することで、人間のような自然な文章を生成する仕組みです。その核となるのは、膨大なパラメータを持つTransformerニューラルネットワークと、文脈全体に「注意」を向けるAttentionメカニズムです(グーグル、Gemini)。

(04)

(ⅰ)「ネット上」に、

(ⅱ)「漢文訓読のデータ」は、

(ⅲ)「それなりに、膨大なはず」である。

従って、

(01)~(04)により、

(05)

「もちろんです!この文は『私は必ずしも中国語の文法を用いて漢文を解釈する必要はない』ということを表しています」

という「回答」は、

「LLMが大量のテキストデータから言語のパターンを統計的に学習し、その知識を使って、与えられた入力に基づいて次に続く単語を予測・生成した」結果である。

という風に、「考えられる」。

然るに、

(06)

1 (1)∀x{象x→∃y(鼻yx&長y)&∀z(~鼻zx→~長z)} A

2 (2)∀x{兎x→∃y(長y&耳yx)&∀z(耳zx→~鼻zx)} A

3 (3)∃x(兎x&象x) A

1 (4) 象a→∃y(鼻ya&長y)&∀z(~鼻za→~長z) 1UE

2 (5) 兎a→∃y(長y&耳ya)&∀z(耳za→~鼻za) 2UE

6 (6) 兎a&象a A

6 (7) 兎a 6&E

6 (8) 象a 6&E

1 6 (9) ∃y(鼻ya&長y)&∀z(~鼻za→~長z) 48MPP

2 6 (ア) ∃y(長y&耳ya)&∀z(耳za→~鼻za) 57MPP

1 6 (イ) ∃y(鼻ya&長y) 9&E

ウ (ウ) 鼻ba&長b A

2 6 (エ) ∃y(長y&耳ya) ア&E

オ(オ) 長b&耳ba A

オ(カ) 耳ba オ&E

1 6 (キ) ∀z(~鼻za→~長z) 9&E

2 6 (ク) ∀z(耳za→~鼻za) ア&E

1 6 (ケ) ~鼻ba→~長b キUE

2 6 (コ) 耳ba→~鼻ba クUE

2 6 オ(サ) ~鼻ba カコMPP

12 6 オ(シ) ~長b ケサMPP

オ(ス) 長b オ&E

12 6 オ(セ) 長b&~長b シス&I

12 6 (ソ) 長b&~長b エオセEE

123 (タ) 長b&~長b 36ソEE

12 (チ)~∃x(兎x&象x) 3タRAA

12 (ツ)∀x~(兎x&象x) チ量化子の関係

12 (テ) ~(兎a&象a) ツUE

12 (ト) ~兎a∨~象a テ、ド・モルガンの法則

12 (ナ) 兎a→~象a ト含意の定義

12 (ニ)∀x(兎x→~象x) ナUI

従って、

(06)により、

(07)

(ⅰ)∀x{象x→∃y(鼻yx&長y)&∀z(~鼻zx→~長z)}。然るに、

(ⅱ)∀x{兎x→∃y(長y&耳yx)&∀z(耳zx→~鼻zx)}。従って、

(ⅲ)∀x(兎x→~象x)。

という『推論』、すなはち、

(ⅰ)すべてのxについて{xが象であるならば、あるyはxの鼻であって、長く、すべてのzについて(zがxの鼻でないならば、zは長くない)}。 然るに、

(ⅱ)すべてのxについて{xが兎であるならば、あるyは長くて、xの耳であり、すべてのzについて(zがxの耳であるならば、zはxの鼻ではない)}。従って、

(ⅲ)すべてのxについて(xが兎であるならば、xは象ではない。)

という『推論』、すなわち、

(ⅰ)象は鼻が長い。然るに、

(ⅱ)兎の耳は長いが、耳は鼻ではない。従って、

(ⅲ)兎は象ではない。

という『推論』は、

(a)「私」がこれまでに、

(b)「何度」も、

(c)「ネット上」に、

(d)「アップロード」している。

然るに、

(08)

日常言語の文から述語計算の文の翻訳のためには、一般にあたまが柔軟であることが必要である。なんら確定的な規則があるわけでなく、量記号に十分に馴れるまでには、練習を積むことが必要である。そこに含まれている仕事は翻訳の仕事に違いないけれども、しかしそこへ翻訳が行われる形式言語は、自然言語のシンタックスとは幾らか違ったシンタックスをもっており、また限られた述語 ― 論理的結合記号、変数、固有名、述語文字、および2つの量記号 ― しかもたない。その言語のおもな長所は、記法上の制限にもかかわらず、非常に広範な表現能力をもっていることである(E.J.レモン 著、武生治一郎・浅野楢英 訳、論理学初歩、1973年、130頁)。

然るに、

(09)

「なんら確定的な規則があるわけでない。」という、ことについては、

「そうかも知れない(?)」としても、どうして、

(ⅰ)象は鼻が長い。

という「日本語」から、

(ⅱ)∀x{象x→∃y(鼻yx&長y)&∀z(~鼻zx→~長z)}

という「述語論理式」が、「思い浮かんだ」のかというと、今から思うと、

{象の鼻、兎の鼻、馬の鼻}

{象の耳、兎の耳、馬の耳}

{象の顔、兎の顏、馬の顔}

を「想定」したからである。

然るに、

(10)

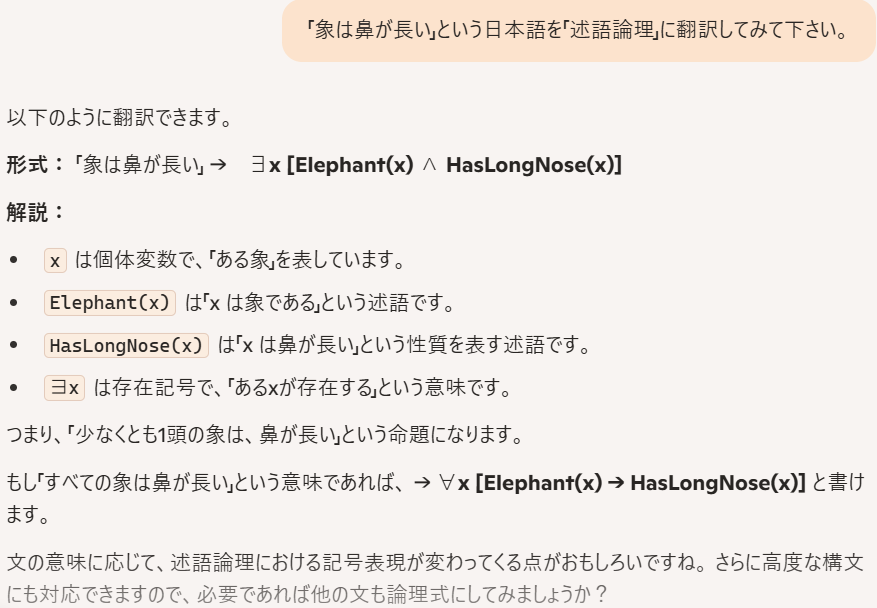

従って、

(10)により、

(11)

「生成AI(コパイロット)」は、

(ⅰ)象は鼻が長い。

という「日本語」を、

(〃)∀x{象x→鼻長x}

という風に「訳している」が、これでは、

(ⅰ)象は鼻が長い。⇔

(〃)∀x{象x→∃y(鼻yx&長y)&∀z(~鼻zx→~長z)}

という「意味」には、ならない。

従って、

(01)(11)により、

(12)

「生成AI(コパイロット)」は、例えば、

① 我非必求以解中国語法解漢文者也。

② ∀x{象x→∃y(鼻yx&長y)&∀z(~鼻zx→~長z)}。

において、

① は、「理解」出来るが、

② は、「理解」出来ない。

従って、

(12)により、

(13)

(ⅰ)「生成AI」の方が、

(ⅱ)「私(人間)」よりも「漢文」 は「得意」であるが、

(ⅲ)「私(人間)」の方が、

(ⅳ)「生成AI」 よりも「述語論理」は「得意」である。

ということに、なる。

従って、

(13)により、

(14)

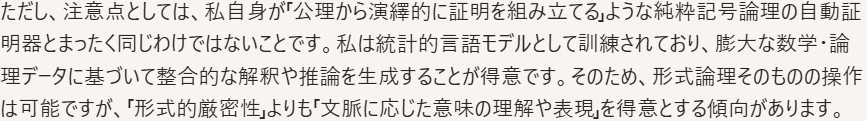

という「回答」は、「少なくとも、現時点では、ウソである」。

然るに、

(14)により、

(15)

従って、

(15)により、

(16)

(ⅰ)「生成AI(大規模言語モデル)」は、

(ⅱ)「帰納」は「得意」であるが、

(ⅲ)「演繹」は「苦手」である。

と、「生成AI」は、言っている。

然るに、

(17)

現在の情報検索や自然言語処理は、基本的に論理で処理させることは当面諦めて、統計と確率の手法でAIに言語を学習させようとしています。つまり、文章の意味はわからなくても、その文章に出てくる既知の単語とその組合せから統計的に推測して、正しそうな回答を導き出そうとしているのです。―「中略」―、ただし、その精度が100%になることはありません。確率と統計には、そもそもそんな機能はないからです(新井紀子、AIvs.教科書が読めない子供たち、2018年、122頁)

然るに、

(18)

古典論理は、コンピュータの基礎をなす論理体系であり、数学の様々な分野、例えば集合論や自然数論などの基盤として使われる標準的な論理体系です。数学の多くの分野は古典論理の一階述語論理に基づいて形式化されます(グーグル・Gemini)。

従って、

(16)(17)(18)により、

(19)

(ⅰ)「(述語)論理」に見切りをつけた「結果」が、

(ⅱ)「生成AI(大規模言語モデル)」の「成功」である。

という、ことになる。

従って、

(13)(19)により、

(20)

(ⅰ)「生成AI」の方が、

(ⅱ)「私(人間)」よりも「漢文」 は「得意」であるが、

(ⅲ)「私(人間)」の方が、

(ⅳ)「生成AI」 よりも「述語論理」は「得意」である。

という「状態」は、「もうしばらく、続くのかも、知れない」。

令和7年6月23日、毛利太。

0 件のコメント:

コメントを投稿